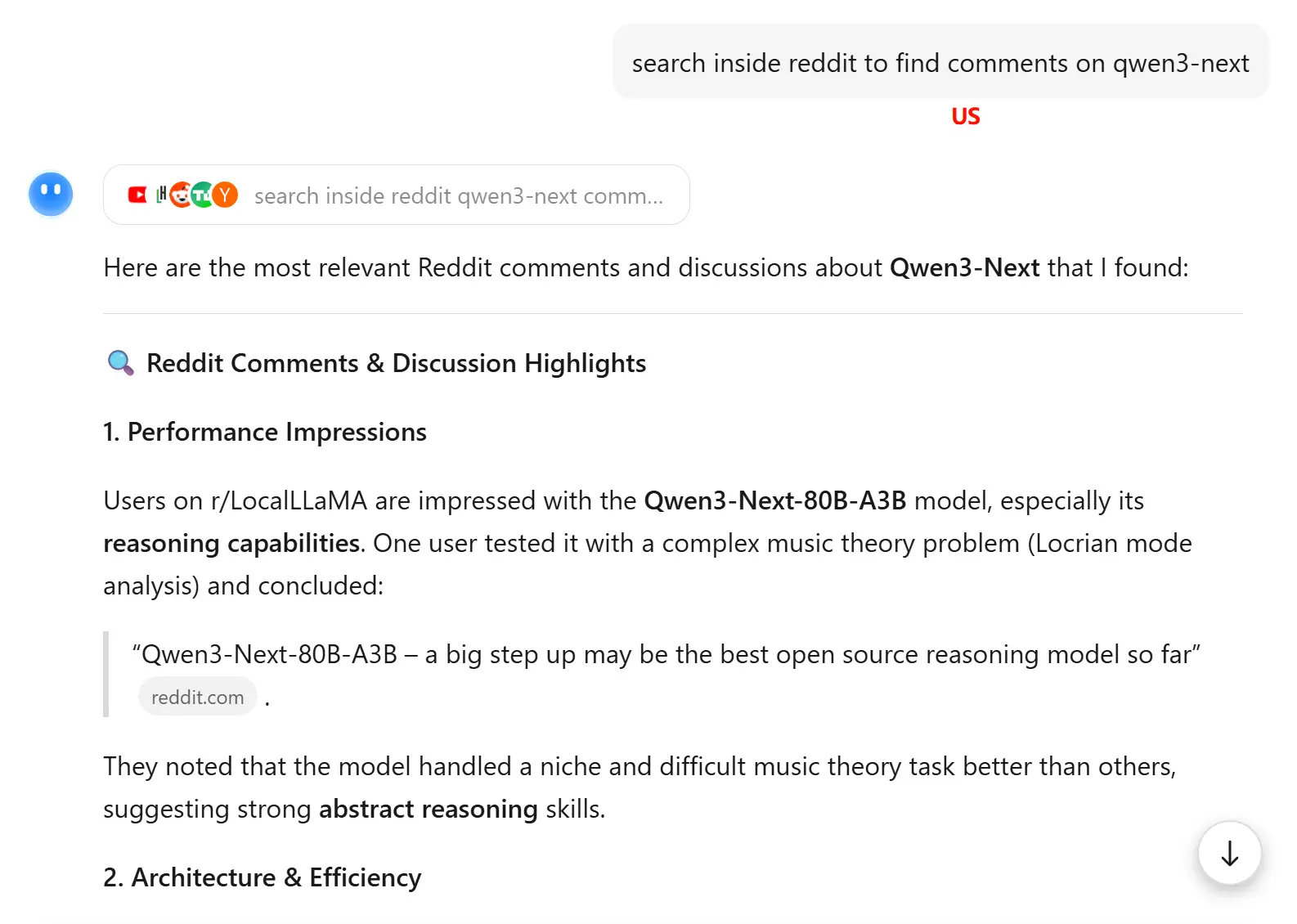

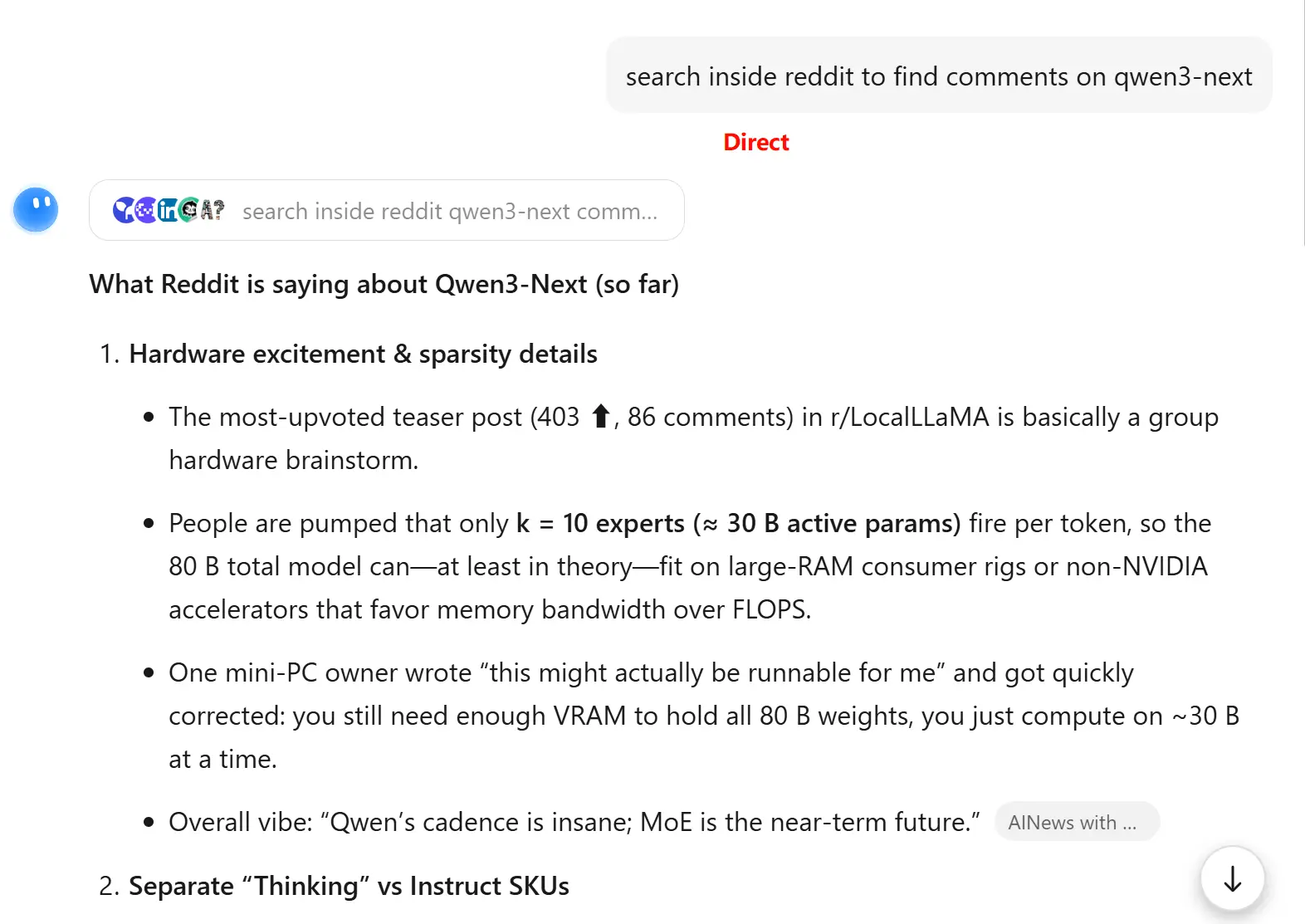

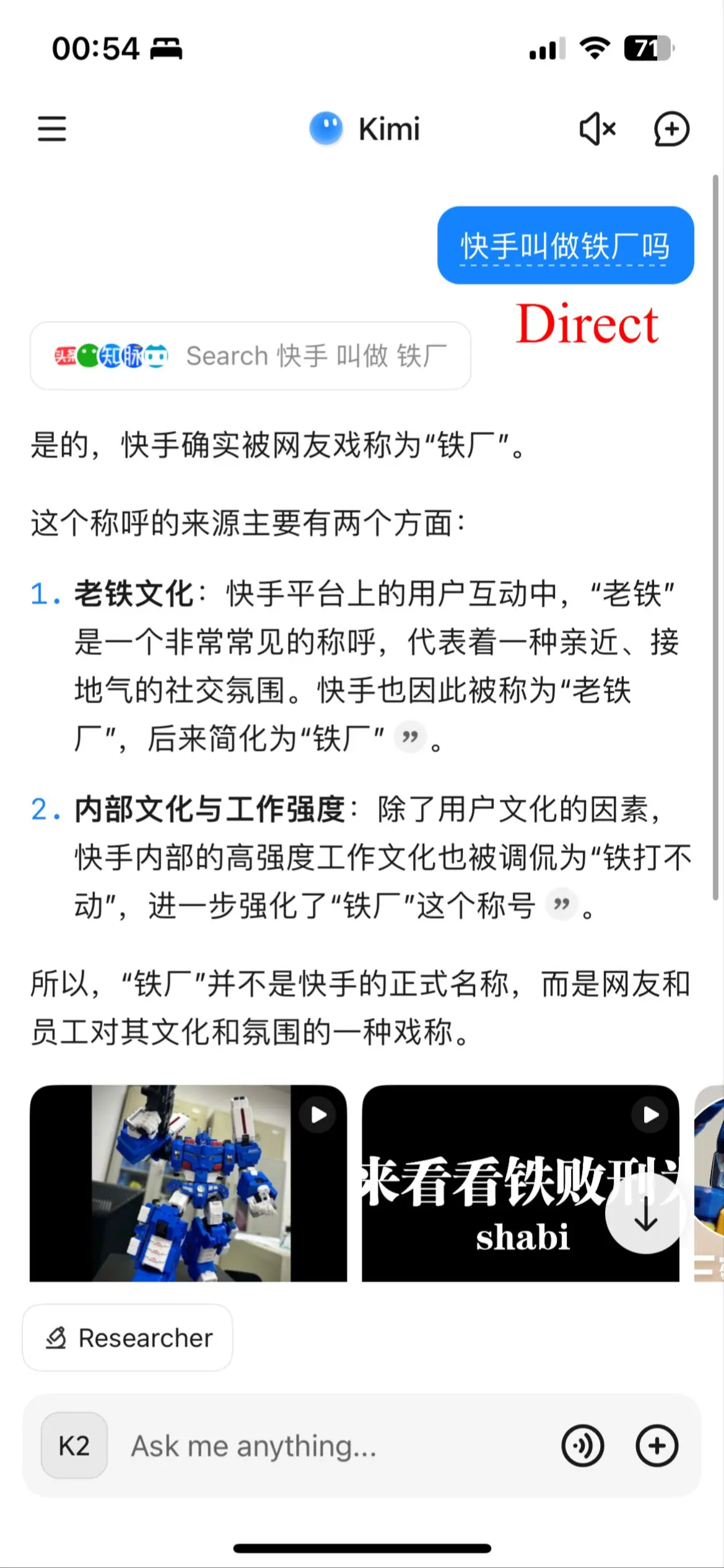

2025-09-18 使用美国节点访问 kimi.com

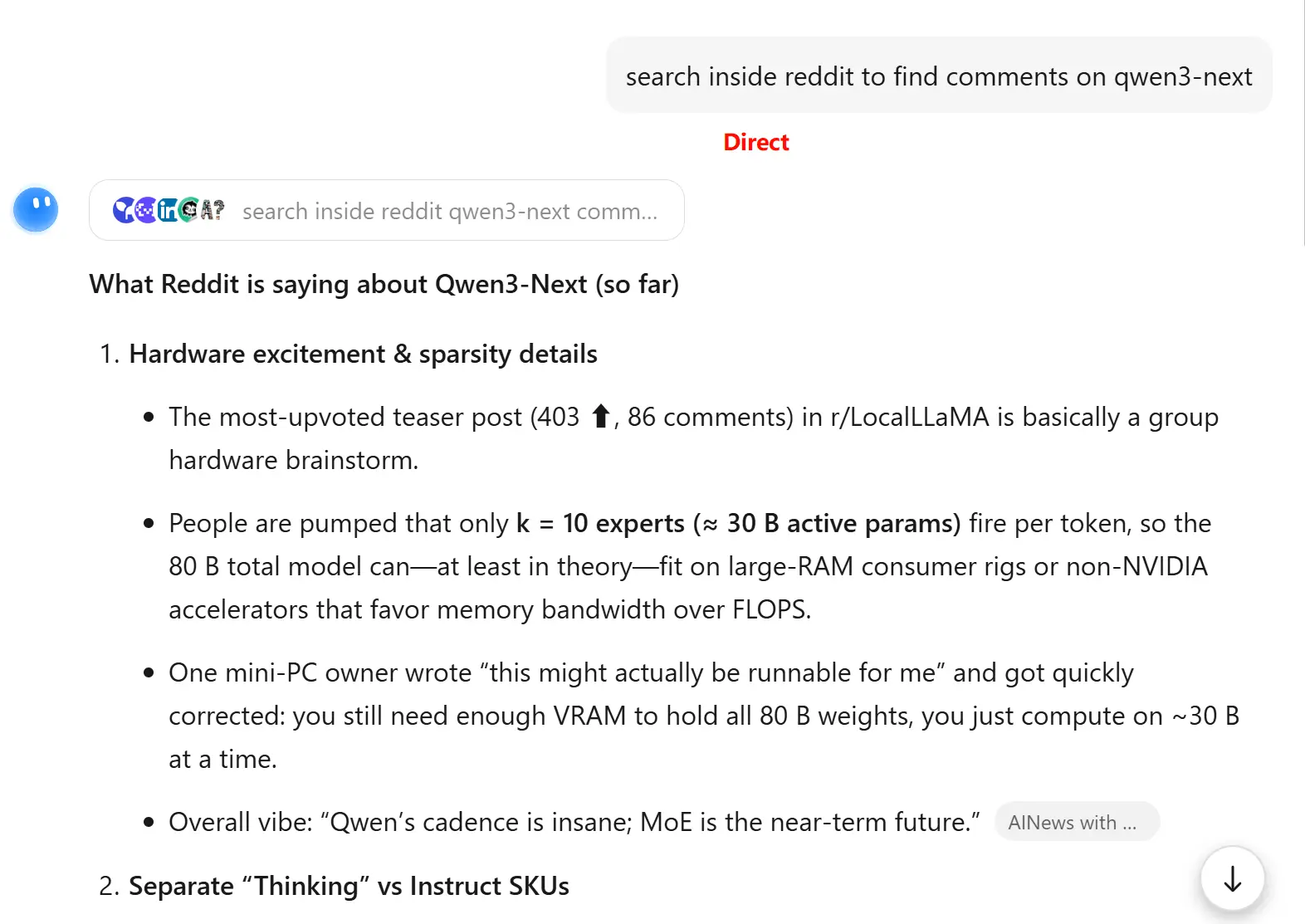

偶然发现使用美国节点并且界面为英文访问 kimi.com 时,能触发不同的搜索源,在某些场景下可能带来更好的搜索效果。

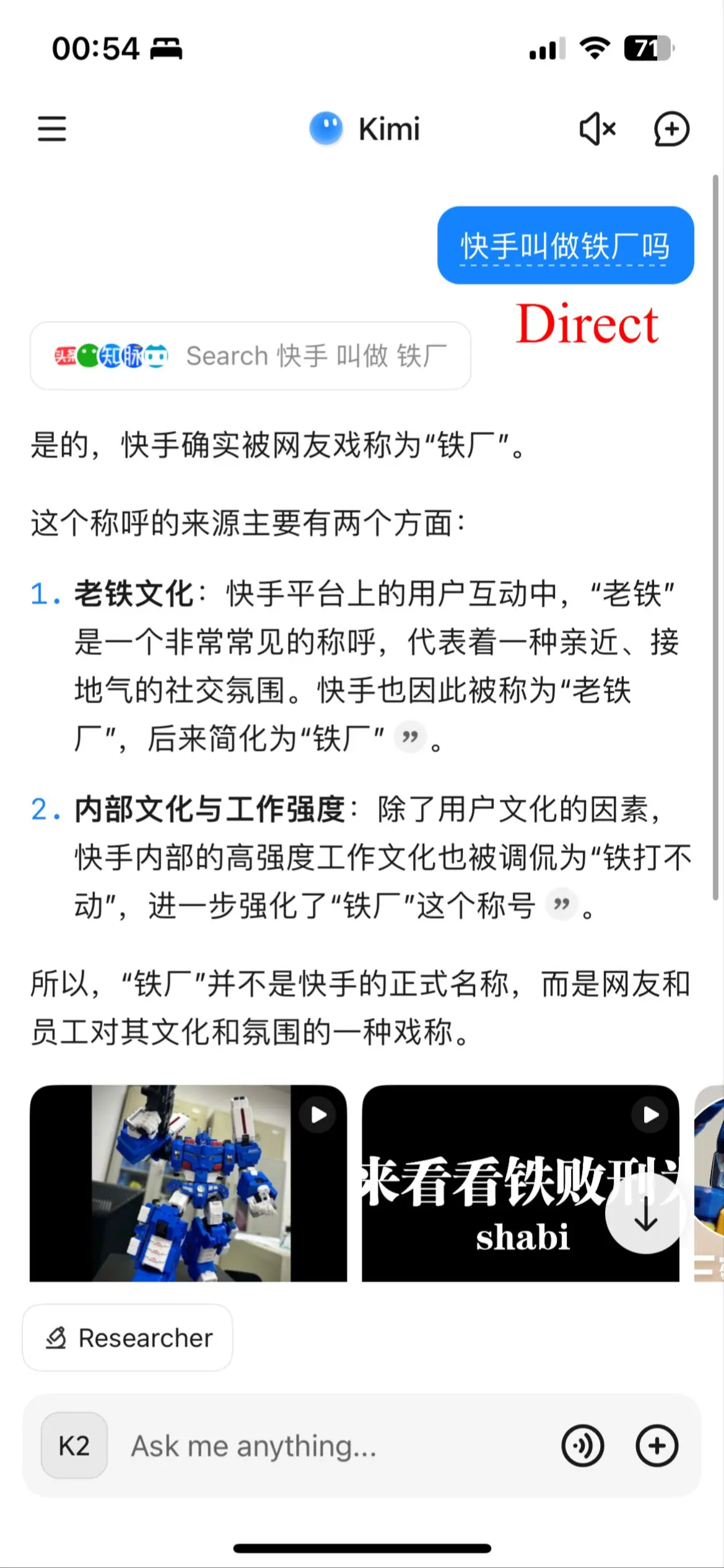

但有时候效果会变差:

偶然发现使用美国节点并且界面为英文访问 kimi.com 时,能触发不同的搜索源,在某些场景下可能带来更好的搜索效果。

但有时候效果会变差:

一些在 Notion 上分享的内容现在可以从侧边栏的“发现”标签打开,这些内容比博客本身编辑起来更方便(指📱编辑),所以我也能更加频繁地创作。它们通常为较短的内容,可以当作周报来看!

今天发现很有意思的一件事情:配备 4090 显卡的服务器上安装 torch 之后,显示的架构并没有 sm_89,也没有 PTX(compute_xx)来支持 JIT。

(minimind) ➜ ~ python -c 'import torch;print(torch.cuda.get_arch_list())'

['sm_50', 'sm_60', 'sm_70', 'sm_75', 'sm_80', 'sm_86', 'sm_90']

(minimind) ➜ ~

sm_89 not listed in the torch.cuda.get_arch_list() - PyTorch Forums 这个讨论说明 sm_89 和 sm_86 是完全兼容的,除了 FP8 支持,这些 kernels 被专门处理。

今天在尝试 Microsoft Copilot 和 Windsurf。

参考 https://linux.do/t/topic/480869/ ,解读大模型官网和 IDE 的各种额度限制。里面提到了 Microsoft Copilot 使用了 GPT-4o 和 GPT-o3 mini,之前对 Microsoft Copilot 的感受是比较负面的,看到这个新消息后我也查找了对应的资料(有一说一,Microsoft Copilot 查资料还不如 Grok 做的好):

Table: Summary of Models and Their Uses(来自 Grok3)

| Model | Primary Use | Confirmed By |

|---|---|---|

| GPT-4o | Standard chat functionality | |

| o3-mini high | Think Deeper feature for complex queries | Microsoft Copilot blog release notes, March 19, 2025 (Microsoft Copilot Blog: Release Notes - March 19, 2025) |

最后的感觉是,Microsoft Copilot 的模型其实是不如 ChatGPT 官网的,感觉会笨一点。Mircosoft Copilot 早期响应慢的情况现在也好了很多(不会是因为现在是白天吧)。智力在一众模型中算是垫底的,做点指令遵循任务还行。

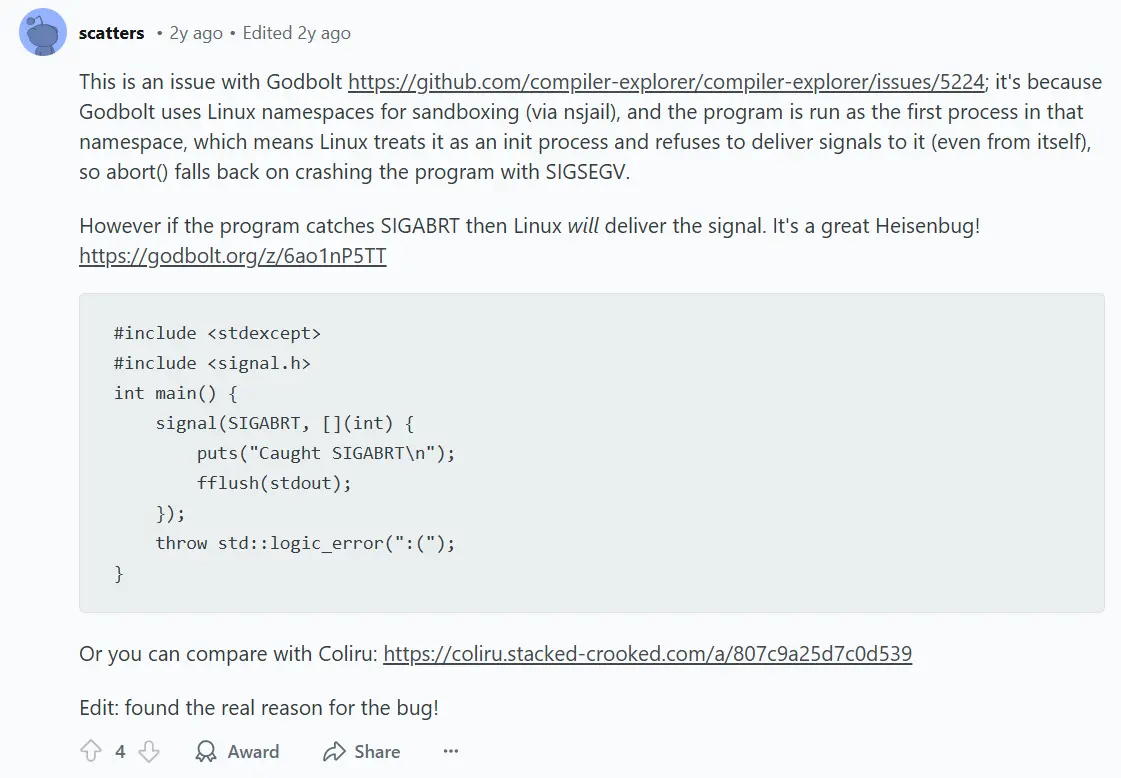

OP 的程序收到了 SIGABRT 信号,但是从 Compiler Explorer 上观察到进程是因为 SIGSEGV 信号退出。原因是 Compiler Explorer 使用了沙盒,无法完全正确地反映程序因何种信号退出。

今天看到一篇介绍 Intel 大小核在 Windows 上面的调度策略 的比较好的帖子。帖子中提到:

单纯将“最大处理器状态”设为 99% 只能关掉小核的睿频,大核仍然是跑满的。

在新时代,如果你想设置大核的“最大处理器状态”,首先你需要在注册表中解锁隐藏的电源选项“第 1 类处理器电源效率的最大处理器状态”(

PROCTHROTTLEMAX1/bc5038f7-23e0-4960-96da-33abaf5935ed),然后对其进行设置才有用。

其他大小核调度策略讲解的帖子:

https://www.bilibili.com/video/BV1jwHhebE8o/ 【系统设计需要知道的延迟等级】

https://github.com/rasbt/LLMs-from-scratch LLM 原理讲解,虽然印刷和电子书籍是要付费的,但是 ipynb 版本都是免费的

http://www.uinio.com/Linux/Vim/ Vim 速查,作者是嵌入式大牛,博客也很有意思

https://github.com/chen08209/FlClash 又一个基于 Clash Core 的 GUI 代理软件